NVIDIA 在人工智能 (AI) 和高性能计算 (HPC) 领域的最新创新是 NVIDIA H200 Tensor Core GPU,它是广受欢迎的 NVIDIA H100的继任者。NVIDIA H100 在过去一年中一直是 AI 应用程序的首选,以其在 AI 训练和推理所需的并行处理方面的出色性能和效率而闻名。随着企业不断寻求技术进步,内存容量和带宽均显着提升的H200将成为 GPU 技术的新标杆。

一、NVIDIA H200 概述

1、首款采用 HBM3e 内存的 GPU,提供 141 GB 容量,速度达 4.8 TB/s

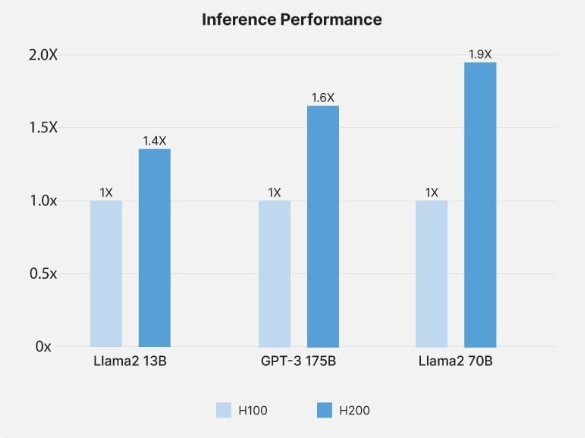

2、GPT-3 175B 推理性能提高 1.6 倍,特定 HPC 应用性能提高 110 倍。

3、提高能源效率并降低总拥有成本 (TCO)

4、大型语言模型(如 Llama2)的推理速度提高 2 倍

二、NVIDIA H200 相对于H100的主要改进

NVIDIA H100 与 NVIDIA H200 的推理性能

NVIDIA H200 相较 NVIDIA H100 有显著的进步,主要体现在内存容量和带宽方面。它是首款集成 141GB HBM3e 内存的 GPU,可提供惊人的 4.8TB/s 带宽。这种增强不仅意味着更大的存储空间,还意味着能够以前所未有的速度处理和传输数据。这种能力对于处理现代 AI 模型和 HPC 任务的大量数据需求至关重要,因为快速访问大型数据集至关重要。

性能方面,NVIDIA H200 明显优于其前代产品,Llama2 70B 的推理速度提高了 1.9 倍,GPT-3 175B 的推理速度提高了 1.6 倍。

对于 HPC 应用,NVIDIA H200 提供了额外的改进,其 HPC 应用性能比传统基于 CPU 的解决方案快 110 倍,性能比前几代产品提高 2 倍。速度和效率的提升并不以更高的能耗为代价。事实上,NVIDIA H200 保持了能源效率和成本效益,符合人们对可持续和经济计算解决方案日益增长的重视。

三、对人工智能和高性能计算的影响

NVIDIA H200 增强的内存和速度对 AI 应用,尤其是大型语言模型 (LLM) 产生了重大影响。141GB HBM3e 内存和 4.8TB/s 带宽有助于更快地处理复杂数据集,这对于训练和运行 GPT-3 或 Llama2 等复杂的 AI 模型至关重要。此功能可以更有效地处理这些模型所需的大量数据,从而缩短训练时间并提高结果的准确性。更快的处理速度还可以实现实时分析和决策,这对于自动驾驶汽车和先进机器人等 AI 驱动的应用至关重要。

在高性能计算 (HPC) 领域,NVIDIA H200 的进步加速了各种应用。例如,在科学研究和模拟中,GPU 快速处理大型数据集的能力可以显著减少复杂计算所需的时间。这种速度在气候建模、基因组测序和物理模拟等领域至关重要,因为这些领域需要快速分析大量数据。通过实现更快、更高效的数据处理,NVIDIA H200 可帮助研究人员更快地获得结果,促进各个科学领域的突破。

NVIDIA H200 的另一个优势是其专注于可持续计算。尽管性能有所提升,但 GPU 仍保持了能源效率,满足了日益增长的环保技术解决方案需求。这一方面对于大型计算设施尤其重要,因为能源消耗和热量产生是主要问题。NVIDIA H200 的节能设计有助于减少计算操作的总体碳足迹,使其成为面向未来的组织的负责任选择。

四、捷易科技在NVIDIA H200 GPU中的作用

在捷易科技,我们专注于设计充分利用最新技术(如 NVIDIA H200 GPU)的定制 IT 基础设施。我们的解决方案专为满足 AI 的特定需求而量身定制,确保充分利用 NVIDIA H200 的功能。我们了解每个客户的需求都是独一无二的,因此我们针对您的特定应用设计系统计算能力、内存和存储。

总而言之,NVIDIA H200代表着GPU技术的最新进展,其引入了一系列突破性特性和创新,为人工智能和高性能计算带来了巨大的可能性。通过深入了解NVIDIA H200的架构、性能和应用前景,我们可以清晰地看到,这一技术将在未来的计算领域发挥着举足轻重的作用。