在当今快速发展的人工智能领域,部署大型语言模型以满足各种推理需求变得至关重要。近期,NVIDIA H200 Tensor Core GPU 的推出引起了广泛关注,展示了一项关键的进步。本文将对这款GPU以及之前发布的NVIDIA H100 和L40S进行深度比较,通过对它们的性能进行评估,更好地了解它们在不同应用场景下的表现,从而帮助我们更好地选择GPU。

一、NVIDIA H200 概述

NVIDIA H200 开创了 GPU 技术的新时代,旨在通过无与伦比的性能和内存能力显著提升 AI 和 HPC 工作负载。

H200 基于 NVIDIA Hopper 架构构建,配备 141GB HBM3e 内存和 4.8TB/s 内存带宽,较其前代 H100 有了实质性的飞跃,增强了生成式 AI 和科学计算能力,同时提高了能源效率并降低了拥有成本。

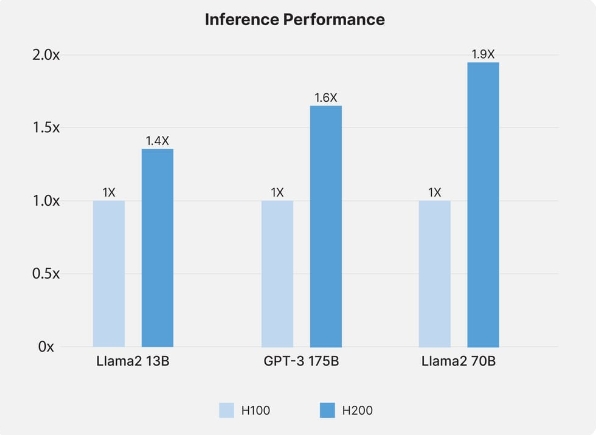

1、预计表现

该 GPU 有望重新定义性能标准,使 H100 对 Llama2 70B 等大型语言模型的推理性能提高一倍,有望对 AI 模型训练和推理任务产生变革性影响。

推理性能来源:NVIDIA

2、H200 推理性能

NVIDIA H200 为 AI 推理树立了新标准,尤其在处理 Llama2 70B 等大型语言模型方面表现突出。与 H100 相比,H200 的推理性能提高了一倍,有助于快速处理和分析,这对于依赖实时数据解释的应用程序至关重要。这种增强的功能使企业能够高效部署更复杂的 AI 模型,从而显著提高 AI 驱动解决方案的响应时间和准确性。

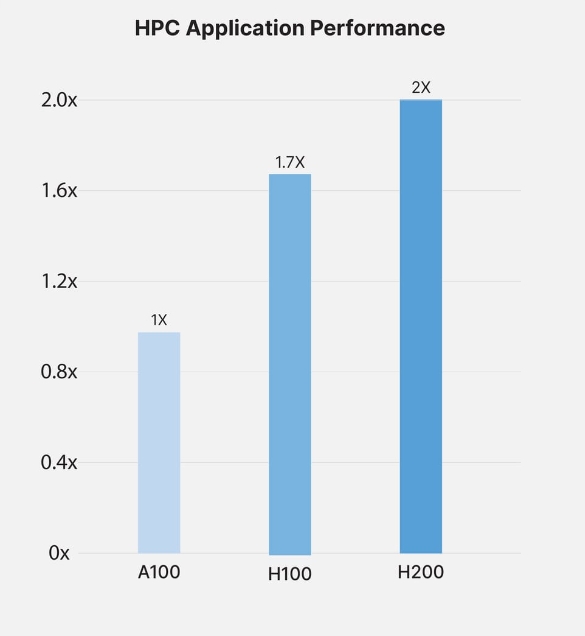

HPC 应用程序性能来源:NVIDIA

3、HPC 性能

在高性能计算领域,H200 凭借显着的内存带宽和处理能力改进脱颖而出。GPU 架构配备 141GB HBM3e 内存和 4.8TB/s 带宽,确保在内存密集型 HPC 应用中提供无与伦比的性能。这些进步加快了数据传输速率并减少了复杂计算中的瓶颈,使研究人员和工程师能够在模拟、科学研究和人工智能任务中更快地获得结果。

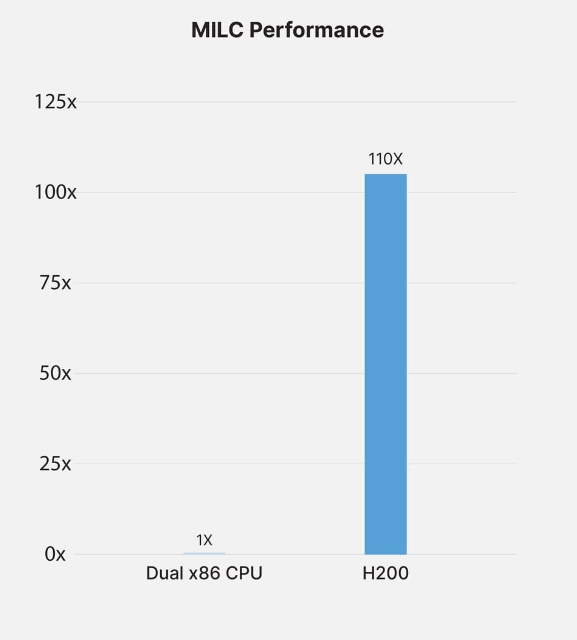

MILC 性能来源:NVIDIA

4、MILC 性能

对于 MIMD 格点计算 (MILC),即量子色动力学 (QCD) 模拟中的关键组件,H200 GPU 提供了显著的性能提升。利用其卓越的内存带宽和计算效率,H200 显著加快了 MILC 数据集的处理速度。这种加速对于推进我们对量子现象的理解和促进粒子物理研究的突破至关重要。H200 的功能确保可以更有效地访问和操作数据,与前几代 GPU 相比,性能指标呈指数级增长,从而大大加快了这一专业领域的洞察时间。

5、未来用例

实现先进的人工智能研究和开发

促进更复杂和更大规模的模型训练

推动科学计算和发现的突破

二、NVIDIA H100 概述

作为NVIDIA在AI和HPC领域的旗舰产品,H100 GPU体现了加速AI模型和管理大数据集的技术巅峰,在数据中心和研究领域得到广泛认可。

H100 先进的架构和内存功能使其能够灵活应对复杂的 AI 和 HPC 挑战,从而提供显著的计算和模型训练效率。

1、表现

H100 在 AI 训练和推理方面表现出色,有助于加快数据处理和模型迭代,这对于高风险应用至关重要。

2、用例

深度学习计划和项目

跨学科的科学模拟

企业和研究环境中的大规模人工智能部署

三、NVIDIA L40s 概述

NVIDIA L40S 专为专业可视化和 AI 推理而设计,采用 Ada Lovelace 架构,是一款适用于创意和设计导向任务的多功能 GPU。

L40S 擅长处理密集的图形工作负载和 AI 驱动的应用程序,提供强大的计算能力和图形性能组合,满足广泛的专业需求。

1、表现

L40S 表现出了渲染和人工智能驱动设计的效率,其性能凸显了其在需要图形和计算能力的应用程序中多功能性和实用性。

2、用例

虚拟设计和沉浸式环境

内容创作和多媒体项目

复杂的 3D 建模和动画

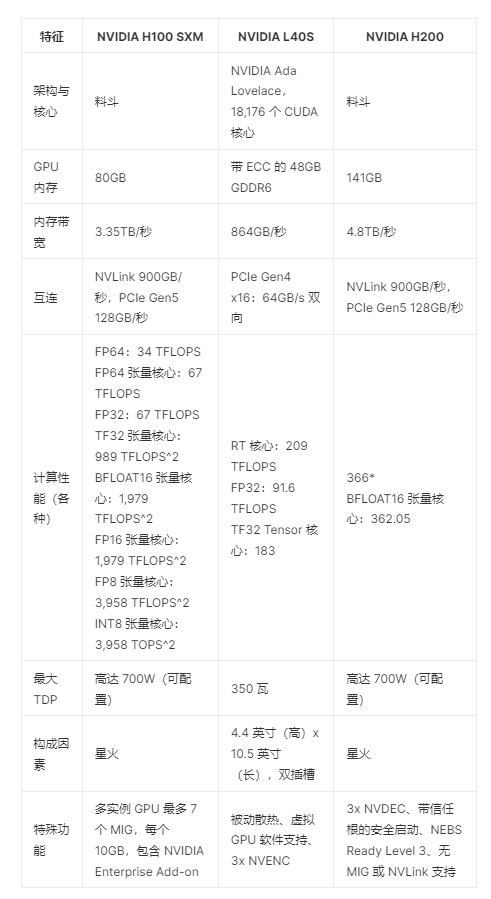

四、NVIDIA H200、H100 和 L40S规格比较

综上所述,通过对NVIDIA H200、NVIDIA H100和NVIDIA L40S的性能进行比较,我们可以清楚地看到它们在推理任务中的表现差异。从 H200 在 AI 和 HPC 方面的革命性功能、H100 在类似领域的性能,到 L40S 在可视化和 AI 推理方面的专业化,捷易科技将这些 GPU 集成在一起,开发出重新定义 IT 基础设施和 AI 应用程序功能的解决方案。