NVIDIA H200 GPU 是人工智能领域备受期待的下一个产品。NVIDIA 展示了 H200 的一些出色规格,其内存容量几乎是其前代产品的两倍。和H100一样, 两款 GPU 均基于强大的Hopper 架构,针对更大的 AI 和 HPC 工作负载进行了增强。那么NVIDIA H100 与 H200 GPU有什么不同?下面全面比较一下。

一、NVIDIA H100 与 H200 基准测试

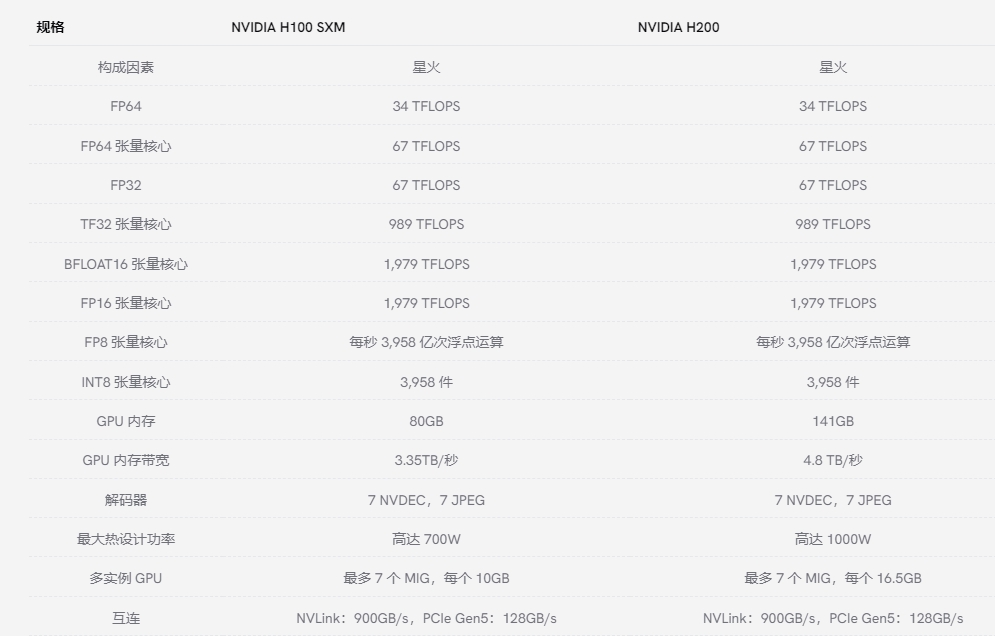

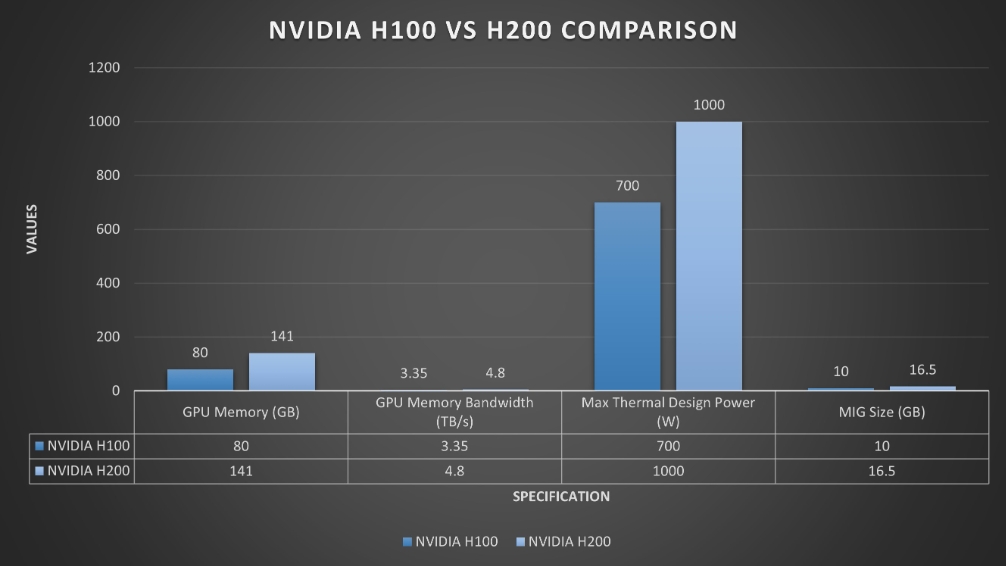

H100 令人印象深刻,而 H200 则进一步提升了其功能。它是第一款采用HBM3e 内存,内存容量为 141 GB,几乎是 H100 的两倍。增加的内存大小对于 AI 来说意义重大,因为它允许将更大的模型和数据集直接存储在 GPU 上,从而减少与数据传输相关的延迟。

H200 的 4.8 TB/s 内存带宽较 H100 的 3.35 TB/s 有了显著提升,表明其能够更快地将数据传输到处理核心,这对于需要高吞吐量的工作负载至关重要。

对于内存密集型 HPC 任务(如天气建模),H200 的卓越内存带宽意味着数据可以在 GPU 内存和处理核心之间更自由地流动,从而减少瓶颈并缩短洞察时间。据报道,HPC 任务的性能提升高达 110 倍,这表明 H200 具有处理高度复杂模拟的潜力,使研究人员和工程师能够在更短的时间内取得更多成果。

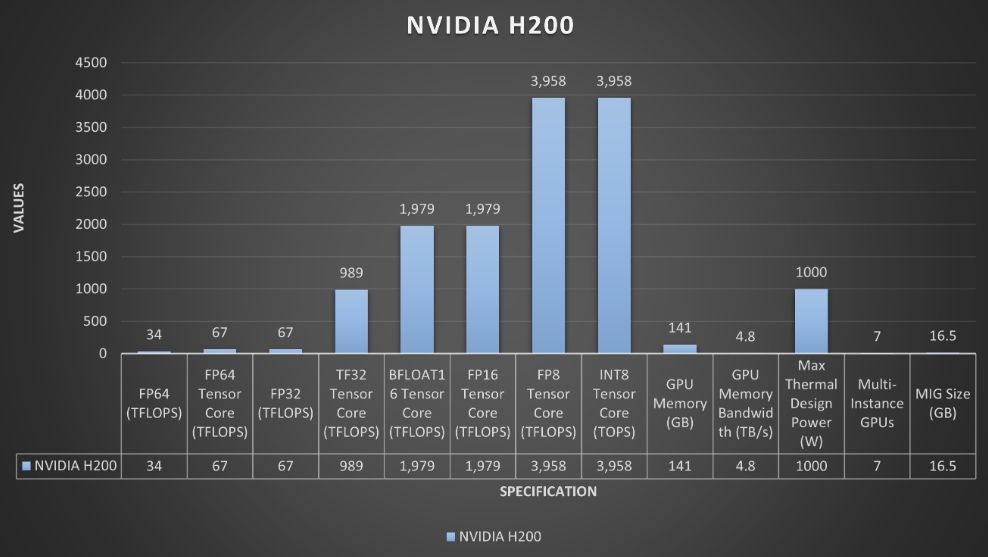

H200 在 FP64 和 FP32 操作中保持与 H100 相同的性能指标。FP8 和 INT8 性能也没有区别,每个类别均为 3,958 TFLOPS。这仍然令人印象深刻,因为 INT8 精度在计算效率和模型精度之间取得了平衡,并且通常用于计算资源非常宝贵的边缘设备。

H200 不仅性能增强,而且能耗水平与 H100 相同。50%减少能源用于 LLM 任务,再加上加倍的内存带宽,可将其总体拥有成本 (TCO) 降低 50%。

二、H200 比 H100 快多少?

NVIDIA H200 GPU 的性能优于 H100,在特定生成式 AI 和 HPC(高性能计算)基准测试中性能提升高达 45%。这一改进主要归功于 H200 的 HBM3e 增强内存容量和更大的内存带宽,以及热管理方面的优化。性能增强的确切程度可能因特定工作负载和设置而异。

三、NVIDIA H100 与 H200 MLPerf 推理基准测试

让我们看看 NVIDIA H100 与 NVIDIA H200 的比较MLPerf 推理分析。

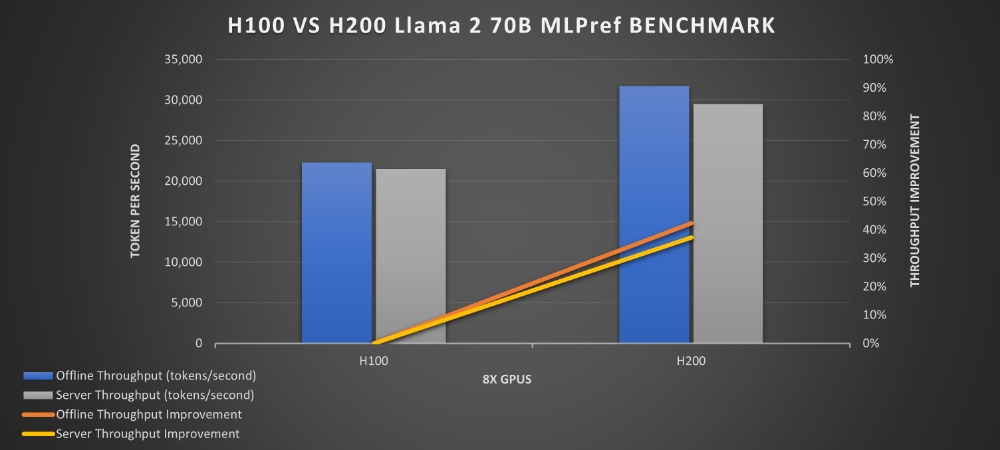

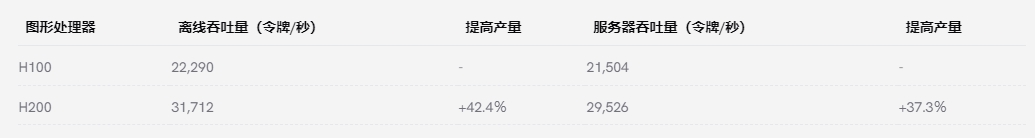

以下是 H100 与 H200 在处理推理任务方面的比较,我们通过查看它们在特定时间范围内可以生成多少个 token 来进行对比。这种方法为评估它们的性能提供了一个实用的指标,尤其是在与自然语言处理相关的任务中:

根据MLPerf Inference v4.0 性能基准规定Llama 2 70B 型号。其中,H100在离线场景下达到了22290个代币/秒的吞吐量,H200在相同场景下达到了31712个代币/秒的吞吐量,性能大幅提升。

在服务器场景下,H100 达到了 21504 个 token/秒,而 H200 达到了 29526 个 token/秒,这意味着在服务器场景下,H200 的吞吐量比 H100 提高了 37%,性能提升非常明显。在离线场景下,也有明显的提升。

造成这种情况的原因归结为以下几点:

1、H200 的内存和带宽提升:

与 H100 相比,H200 的内存更大(141GB),带宽更高(4.8 TB/s),分别约为 H100 的 1.8 倍和 1.4 倍。这有助于 H200 比 H100 容纳更大的数据量,从而减少不断从较慢的外部内存中获取数据的需要。更高的带宽允许内存和 GPU 之间更快地传输数据。

有了这些,H200 可以处理大型任务,而无需张量并行(拆分数据)或管道并行(分阶段处理)等复杂技术。

2、提高推理吞吐量:

由于没有内存和通信瓶颈,H200 可以将更多的处理能力用于计算,从而加快推理速度。Llama 测试的基准测试证明了这一优势,即使在与 H100 相同的功率水平 (700W TDP) 下,H200 也能实现高达 28% 的提升。

3、性能提升:

基准测试显示,当功耗配置为 1000W 时,H200 在 Llama 测试中的表现比 H100 提高了 45%。

这些比较凸显了 H200 GPU 相对于 H100 所取得的技术进步和性能增强,特别是在通过更大的内存容量、更高的内存带宽和改进的热管理来处理像 Llama 2 70B 这样的生成式 AI 推理工作负载的需求方面。

随着 GPU 技术快速发展,未来保障是一个重要问题。H200 和 H100 虽然目前处于领先地位,但可能很快就会被新型号所取代。用户需要考虑升级途径和这些 GPU 的潜在过时性,权衡投资最新技术的好处与在不久的将来需要再次升级的可能性。