发展深度学习和 AI 模型的高效运行推动了对更强大的图形处理单元 (GPU) 的需求。如前所述,GPU 已经显著改变了深度学习格局,因为它们并行处理能力。PyTorch是一个深度学习框架,高度依赖图形处理单元(GPU)的计算能力,实现高效的模型训练和推理。

PyTorch利用 GPU 的计算能力来加速深度学习模型的训练和推理过程。GPU 特别适合处理机器学习任务所需的密集计算。

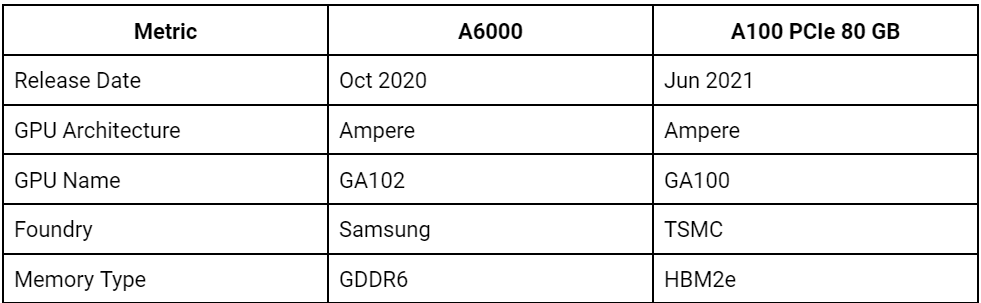

在本文中,我们将比较 NVIDIA A6000 和 A100,评估它们是否适合 PyTorch 工作负载。NVIDIA A6000 和 A100 是用于深度学习的两款功能强大的 GPU。两者都是 NVIDIA 的一部分Ampere 架构。这些 GPU 专为高性能计算工作负载和高级 AI 应用而设计。A6000 面向需要强大 GPU 能力的专业人士,而 A100 则专为数据中心打造,代表了当前 GPU 技术的前沿。

什么是 PyTorch?

PyTorch是一个基于Torch 库,广泛用于自然语言处理和人工神经网络等应用。PyTorch 因其易用性、灵活性和高效的内存使用率而广受欢迎。

PyTorch 的独特之处在于动态计算图,也称为运行定义图。这允许开发人员动态更改网络的行为方式。图形是在创建操作时实时创建的,从而为构建复杂架构提供了更大的灵活性。这种动态特性使 PyTorch 特别适合研究和原型设计。

然而,这种灵活性也伴随着计算需求高,这就是 GPU 发挥作用的地方。GPU 可以同时处理多个计算,使其成为大规模矩阵运算的理想选择深度学习算法。 为了PyTorch用户,GPU 的性能会显著影响训练模型的速度、可训练模型的大小以及最终可解决的问题类型。

本质上,合适的 GPU 可以释放 PyTorch 的全部潜力,使研究人员和开发人员能够突破 AI 的极限。

RTX A6000 适合深度学习吗?

是的,RTX A6000 对深度学习很有效。它提供高 CUDA 核心数和 48GB 内存,适用于图像分类和自然语言处理等任务中的中型深度学习模型

NVIDIA A6000 与 A100 GPU 概述

NVIDIA RTX A6000是一款功能强大的专业级显卡。它旨在为设计师、工程师、科学家和艺术家提供高性能视觉计算。

A6000 配备 48 GB 超高速 GDDR6 内存,可通过 NVLink 扩展至 96 GB。如此大的内存容量使其成为数据密集型任务的理想选择,例如深度学习应用程序所需的任务。

A6000 采用 8 nm 工艺制造,基于 GA102 图形处理器。在性能方面,A6000 即使在要求苛刻的视觉应用中也能提供流畅的体验。它结合了 84 个第二代 RT Core、336 个第三代 Tensor Core 和 10,752 个 CUDA® 核心,使其成为 AI 计算的强大引擎。

另一方面,NVIDIA A100 GPU是一款专为 AI 和高性能计算工作负载设计的高端显卡。我们已经全面讨论了 A100 GPU。

A6000 和 A100 GPU 具有强大的计算能力和大内存容量,在 AI 和机器学习中发挥着重要作用。它们可以处理复杂的任务,例如训练大型神经网络、运行模拟、处理大型数据集以及支持 AI 的高级研究。

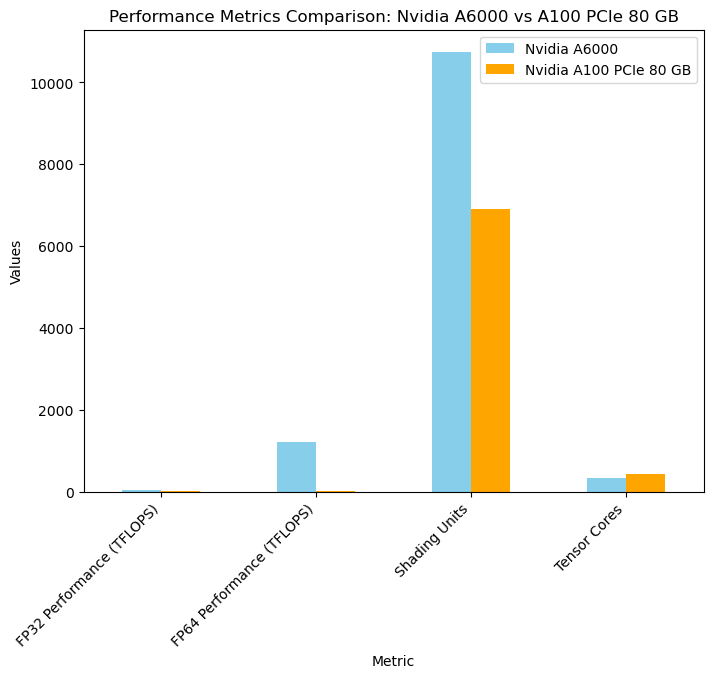

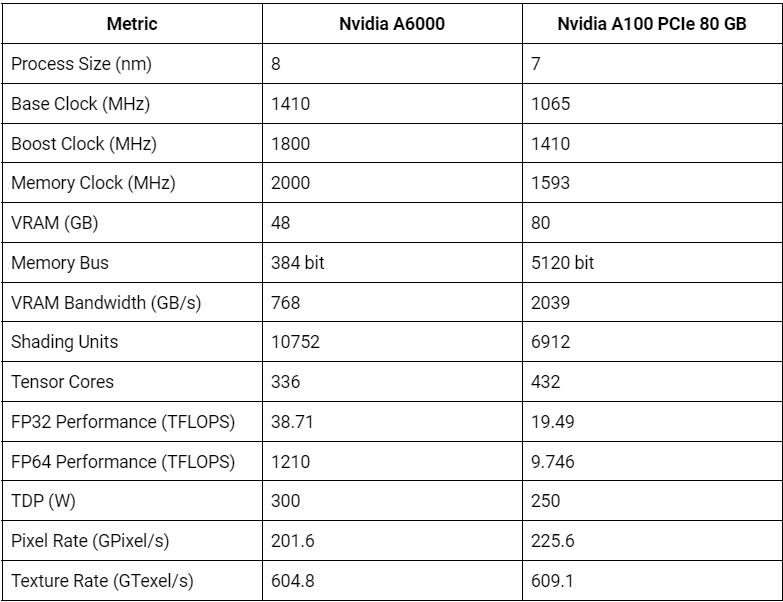

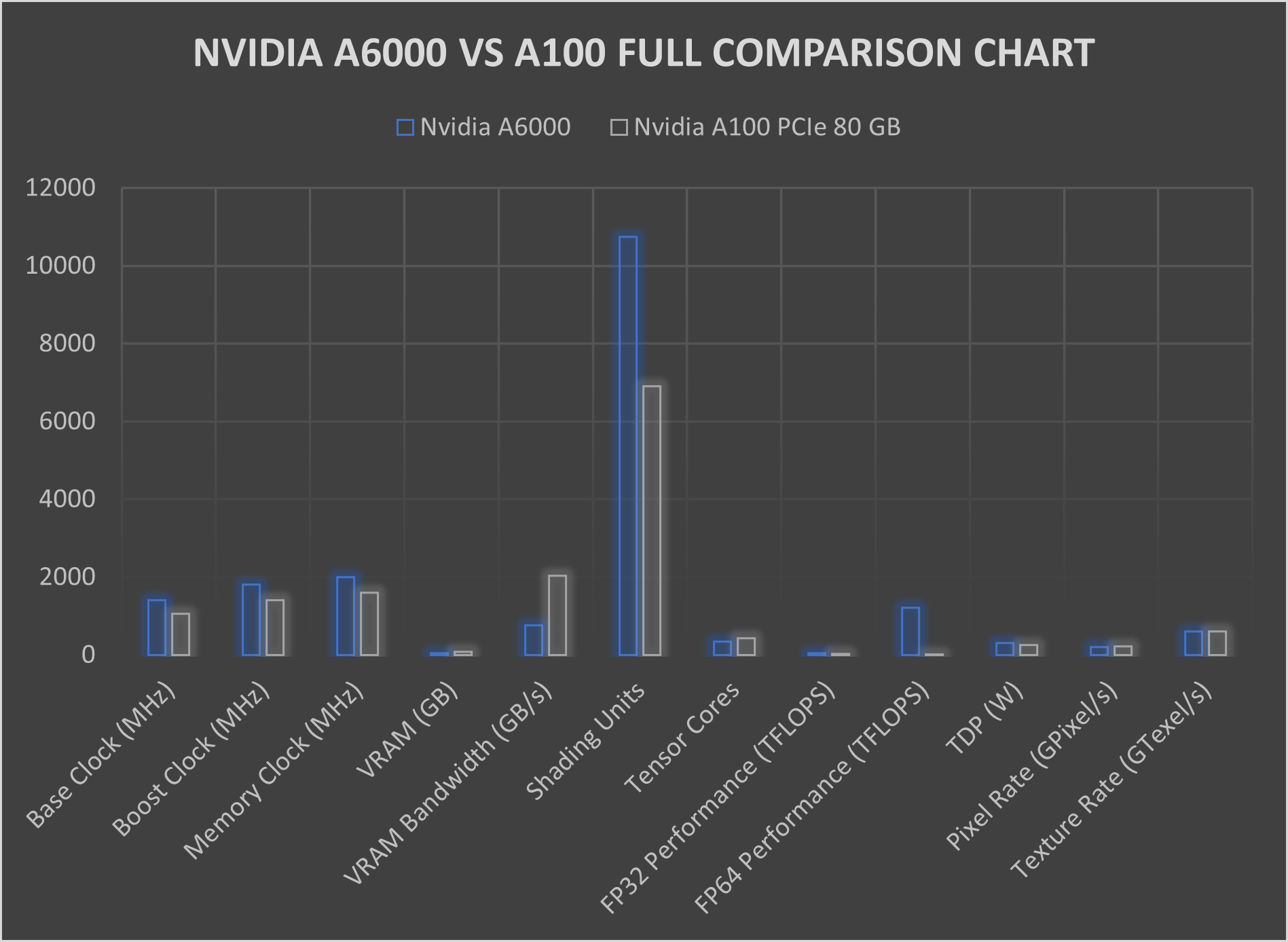

A6000 和 A100 的性能基准和分析

在评估 GPU 的 PyTorch 任务性能时,必须考虑其基准和训练和推理能力。

这些是 NVIDIA A6000 和 A100 GPU 的基准:

让我们根据实际用例来分析 A6000 和 A100 GPU 在这些典型的 PyTorch 任务中的性能:

1.培训表现:

训练深度学习模型需要重大计算功率和内存带宽。A100 GPU 的内存带宽更高,为 1.6 TB/s,性能优于 A6000,后者的内存带宽高达 768 GB/s。更高的内存带宽可实现更快的数据传输,从而缩短训练时间。

基准测试表明,A100 GPU 表现出色。例如,在图像分类任务中使用流行的数据集,A100 表现出比上一代 GPU 更快的训练时间。这在训练需要大量内存带宽和计算能力的大规模模型时尤其明显。

实际用例也凸显了 A100 在训练任务中的实力。例如,在自然语言处理 (NLP) 任务中,例如训练基于 Transformer 的模型进行语言翻译或情感分析,A100 更高的内存带宽和 Tensor Cores 有助于加快收敛速度和缩短训练时间。

A100 GPU 用于什么?

A100 GPU 可用于高性能计算和高级深度学习任务。它们擅长训练复杂的神经网络和混合精度计算,非常适合尖端 AI 应用和大规模模型训练。

2.推理性能:

推理或使用经过训练的模型对新数据进行预测是深度学习的另一个重要方面。A100 GPU 的 Tensor Cores 显著增强了推理性能,尤其是对于混合精度计算。这些 Tensor Cores 可以加快计算速度,从而缩短推理时间。

基准测试表明,A100 GPU 能够令人印象深刻的推理性能跨各种任务。例如,在对象检测任务中使用流行的类似 COCO 的数据集,A100 已经证明推理时间更快比上一代 GPU 更胜一筹。这在需要快速准确检测物体的实时应用中尤其有用,例如自动驾驶汽车或视频监控。

实际用例进一步强调了 A100 在推理任务中的优势。例如,语音识别任务,A100 的 Tensor Cores 可以更快地处理音频数据,从而提高实时转录的准确性。同样,在生成建模任务中,例如训练用于图像合成的生成对抗网络 (GAN),A100 的增强性能允许更快的生成高质量图像。

虽然 A100 GPU 凭借其出色的内存带宽和 Tensor Core 在 PyTorch 训练和推理任务中的表现通常优于 A6000,但 A6000 对于中型模型仍然有效,特别是在图像分类和对象检测等应用中。两款 GPU 之间的选择取决于应用程序的特定需求。

A6000 拥有更高的 CUDA 核心数和内存容量,因此非常适合不需要大量混合精度计算的任务。相反,对于需要更快数据传输和更高混合精度性能的大规模深度学习任务,A100 是最佳选择。选择合适的 GPU 需要了解每种 GPU 的独特优势,以满足预期 PyTorch 应用程序的要求。

要将 NVIDIA A6000 和 NVIDIA A100 GPU 用于深度学习项目,请利用捷智算平台的令人印象深刻的 GPU 选择按需提供。借助捷智算平台,您可以无缝访问和利用NVIDIA A6000和A100 GPU,充分发挥 PyTorch 应用程序的潜力。

无论您需要训练大规模模型、执行实时推理还是处理复杂的深度学习任务,捷智算平台都能提供您需要的基础设施和资源。利用捷智算平台上的 A6000 和 A100 GPU 加速您的深度学习工作流程。

关于捷智算平台

捷智算平台是一个面向所有人的更公平的云计算平台。它通过利用闲置数据中心硬件上全球未充分利用的计算能力,提供对分布式资源的访问。它允许用户在世界上第一个民主化的云平台上部署虚拟机,以最优惠的价格在理想的位置找到最佳资源。

捷智算平台旨在通过提供更可持续的经济、环境和社会计算模型,使企业和个人能够将未使用的资源货币化,从而实现公共云的民主化。

我们的平台允许组织和开发人员根据需求部署、运行和扩展,而不受集中式云环境的限制。因此,我们通过简化客户对更广泛的高性能计算和分布式边缘资源池的访问,为客户实现了显著的可用性、接近性和成本效益。