我们真的没有 GPU 计算能力了吗,还是我们只是在 错误的地方寻找 错误类型的GPU?最近,GPU短缺的 消息随处可见。生成式人工智能的爆炸式增长导致了 对以人工智能为中心的 GPU 的疯狂抢购和漫长的等待时间。对于正在成长的提供大规模推理服务的人工智能公司来说,这种 GPU 的短缺并不是真正的问题。 选择合适的 GPU 才是。

AI 推理可扩展性和“合适大小”的 GPU

当今的“GPU 短缺”实际上是由于 使用效率低下以及对不符合大规模 AI 应用程序需求的 GPU 支付过高的费用造成的。大型云计算公司和硬件制造商的营销机器已经成功地说服开发人员,他们 绝对需要最新、最强大的硬件 才能成为一家成功的 AI 公司。

A100 和 H100 非常适合训练高级模型,它们无疑是速度最快、最先进的 GPU,理应受到广泛关注。但这些 GPU 数量不足,而且即使有售,也需要预付款或签订现有合同。

最近有一篇文章,有两点证实了这一点:

即使是 OpenAI 也无法获得足够的 GPU,这严重限制了其近期的发展路线图。由于 GPU 短缺,OpenAI 无法部署其多模式模型。

尽管 Nvidia 试图大幅提高产量,但最高端的 Nvidia GPU H100 仍将缺货。

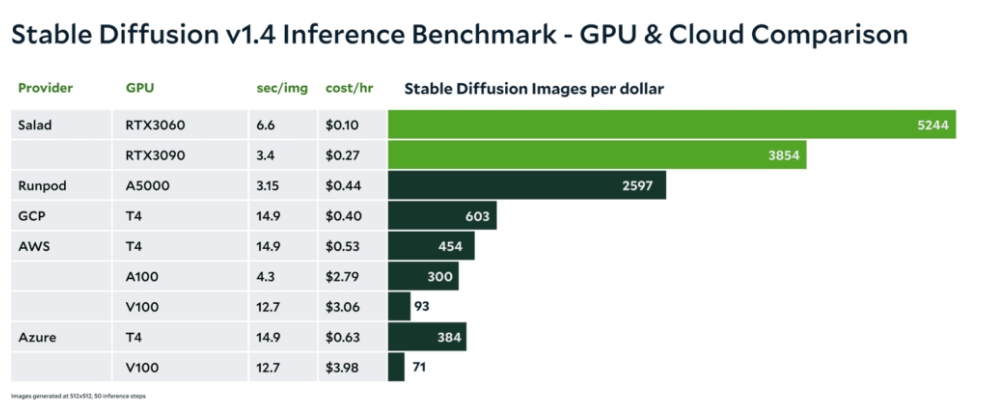

同时,GPU 基准测试数据表明,在许多用例中,您不需要最新、最强大的 GPU。消费级 GPU(RTX3090、A5000、RTX4090 等)不仅具有高可用性,而且 每美元可提供更多的推理,从而大大降低您的云成本。

在正确的阶段选择“合适大小”的 GPU 可以让生成式 AI 公司走上盈利、可扩展的增长之路,降低云成本,并免受“GPU 短缺”的影响。

如何找到“合适尺寸”的 GPU?

在确定适合您应用程序的“合适大小” GPU 时,需要考虑几个因素。第一步是评估应用程序在 AI 模型生命周期的每个阶段的需求。这意味着要考虑数据预处理、训练和推理等任务的不同计算、网络和存储要求。

训练模型

在机器学习模型的训练阶段,通常需要大量的计算资源。这包括使用高性能图形处理单元 (GPU),其数量可能从数百到数千个不等。这些 GPU 需要通过专门设计的集群中的闪电般快速的网络连接进行连接,以确保机器学习模型获得有效训练所需的资源。这些专门设计的集群针对机器学习的特定需求进行了优化,能够处理训练阶段所需的大量计算需求。

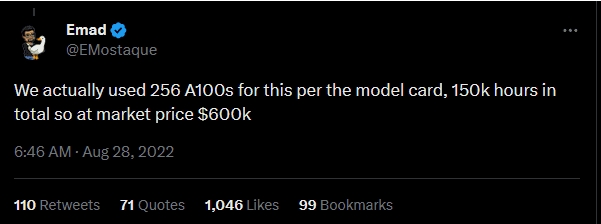

示例:训练Stable Diffusion(大约成本:60 万美元)

服务模型(推理)

在为您的模型提供服务时,可扩展性和吞吐量尤为重要。通过仔细考虑这些因素,您可以确保您的基础设施能够满足不断增长的用户群的需求。这包括注意预算限制和架构考虑。

值得注意的是,在许多例子中,用于 推理的 GPU 要求明显低于用于训练的 GPU 要求。尽管如此,许多人仍继续使用相同的 GPU 执行这两项任务。这可能会导致效率低下,因为硬件可能未针对每项任务的独特需求进行优化。通过花时间仔细评估您的基础设施需求并进行必要的调整,您可以确保您的系统尽可能高效、有效地运行。

示例 1:消费级 GPU 上每美元可获得的图像数量增加 6 倍

在最近的 Stable Diffusion 基准测试中,与专注于 AI 的 GPU 相比,消费级 GPU 每美元可生成 4 至 8 倍的图像。大多数文本转图像领域的生成式 AI 公司都可以使用消费级 GPU 进行大规模推理。经济性和可用性使其成为此用例的赢家。

示例 2:提供Stable Diffusion XL

在最近推出 SDXL 的公告中,Stability.ai 指出 SDXL 0.9 可在仅具有 16GB RAM 和至少 8GB vRAM 的现代消费级 GPU 上运行。

大规模提供“合适规模”的人工智能推理

在捷智算平台,我们深知能够在不花太多钱的情况下大规模提供 AI/ML 推理的重要性。因此,我们创建了一个全球分布的消费级 GPU 网络,该网络从头开始设计,以满足您的需求。我们的客户发现,转向捷智算平台而不是依赖大型云计算提供商不仅可以节省 高达 90% 的云成本,还可以改善他们的产品供应并减少开发运营时间。

示例:24 小时内生成 900 多万张图片,仅需 1872 美元

在最近为客户进行的基准测试中,我们在 24 小时内生成了 920 万张稳定扩散图像,成本仅为 1872 美元 - 全部使用 Nvidia 的 3000/4000 系列 GPU。这意味着每美元可以生成约 5000 张图像,从而为这家图像生成公司节省了大量成本。

使用捷智算平台,您无需担心昂贵的基础设施维护或意外停机。如果它在您的系统上有效,它也可以应用于捷智算平台。相反,您可以专注于真正重要的事情 - 服务于不断增长的用户群,同时保持盈利。

要了解您的用例是否适合消费级 GPU, 请立即联系我们的团队。