我们在捷智算平台上收到的最常见问题之一是如何充分利用我的 GPU?今天针对这个问题,为大家做一个详细的解答,同时分享给大家合适的 GPU 选择指南。

最重要的因素

首先,你需要有足够的 VRAM 来适应你的模型。这应该是你首先要考虑的。

Tensor Core 用于矩阵乘法,这对于任何 AI 应用都至关重要。从 2017 年的 V100 开始,专业 GPU 中引入了 Tensor Core,2018 年的 GeForce 20 系列也引入了消费级 GPU。捷智算平台上的绝大多数 GPU 都配有 Tensor Core,那么问题就在于有多少个呢?

事实上,不是。Tensor Core 非常快 - 快到大多数时候都没有得到充分利用,具体取决于批处理大小。因此,瓶颈通常是带宽,包括内存和互连(GPU 之间)。

FP16 与 FP8

FP8 用 8 位表示数字,而不是之前标准的 FP16 的 16 位。最新的 GPU(例如 H100 和即将推出的 B100)支持针对 FP8 的优化。

精度较低时,模型可以使用较低的 VRAM 和带宽运行,因此计算量也较少。但是,您必须小心,不要显著降低模型性能。如果您已经测试过可以从 FP8 中受益,或者有理由认为可以受益,请确保您使用的是支持 FP8 的 GPU。

最佳推理精选

消费级显卡的性价比通常更高,因为企业级 GPU 的标价明显更高。大多数云提供商不提供消费级 GPU,但捷智算平台提供。

如果您可以将模型装入 24 GB VRAM 卡中,那么 3090 和 4090 的推理价值将非常高。超过 24 GB,您将被迫进入企业领域,而价值却无法接近。如果您尚未确定特定模型,那么将其装入 24 GB VRAM 卡中将大大降低您的推理成本。

除此之外,下一个价值等级是较低级别的企业卡,例如 V100 32 GB、A6000(48 GB)、L40(48 GB)和 6000 Ada(48 GB)。

然后,你终于有了 A100 80 GB 和 H100。如果你需要这么高的性能来进行推理,你肯定会知道的。总的来说,A100 提供了更好的推理价值,而 H100 最适合训练。

企业 GPU

1、扩展计算:NVLink 和 InfiniBand

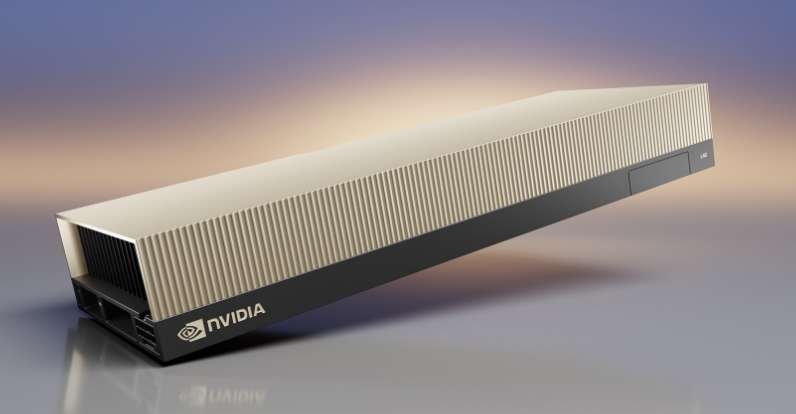

搭载 NVLink 的 NVIDIA A100

由于 GPU 必须互连且受带宽限制,因此将服务器从 1 个 GPU 扩展到 8 个 GPU 并不会自动实现 8 倍性能。现代 GPU 支持更快的互连,因此对于 V100 等较旧的 GPU,这种下降会更加明显。

在捷智算平台上,如果您租用 2x、4x 或 8x H100/A100 服务器,您的 VM 会在可用时自动通过 NVLink 互连。

NVLink 连接服务器内的 GPU,而 InfiniBand 连接多台服务器。预计 InfiniBand 的价格会略有上涨,约为 5-10%。请记住,除非您正在训练非常大的模型,否则这并不是必需的。

对于推理,我们已经看到,运行每个虚拟机 4 个 GPU 且每个 8xH100 节点运行两个实例的开源模型可获得最佳性能,优于运行 2 个 GPU 或 8 个 GPU 的模型。此外,我们已经看到,使用 Triton 推理的 TensorRT-LLM 的吞吐量大约是 vLLM 的两倍。

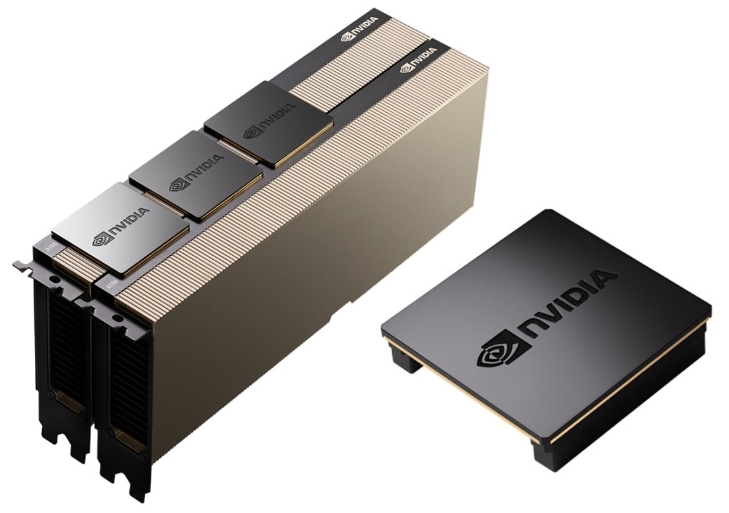

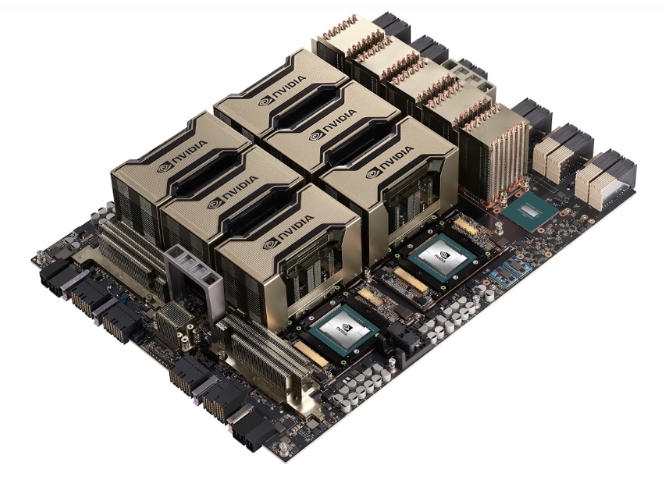

2、SXM 与 PCIe(仅限 H100、A100 和 V100)

NVIDIA A100 SXM4 服务器

SXM 是 NVIDIA 专有的外形尺寸,可提高电力输送、冷却和带宽。仅提供 PCIe 的云提供商通常不会指定他们的 H100 是 SXM 还是 PCIe。这是因为 PCIe 的性能要低得多,最多低 25%!这是因为 H100 PCIe 的内存带宽仅为 2 TB/s,而 SXM5 的内存带宽为 3.35 TB/s。总体而言,SXM 将 GPU 紧密地集成在服务器中,因此它们可以有效地作为单个超大 GPU 运行。对于 A100 和 V100,性能上没有太大差别,所以只要选择更便宜的就行。