使用 DeepChat 的 3 步训练示例,对捷智算平台提供的 NVIDIA H100 SXM5 与 NVIDIA A100 SXM4 进行 GPU 基准测试。

目标

我们使用DeepChat 的 3 步训练示例,对捷智算平台提供的NVIDIA H100 SXM5 实例(由 NVIDIA H100 Tensor Core GPU 提供支持)进行了激动人心的 GPU基准测试。我们将性能与参考 NVIDIA A100 SXM4 Tensor Core 系统进行比较,并在 128 台服务器上的 1,024 个 GPU 上对其可扩展性进行压力测试。

准备事项

每台服务器配备 8 个 NVIDIA H100 SXM5 GPU 和 8 个 400Gb/s NDR InfiniBand 链路。这相当于 640GB 的 GPU 内存和 3200Gb/s 的节点间带宽。

利用完全无阻塞的轨道优化网络拓扑,我们最大限度地提高了全性能并减少了网络冲突,确保服务器之间的InfiniBand 性能大于 750Gbit/s ,这通过一对 InfiniBand 端口之间的双向 ib_write_bw 测试来测量。

所有服务器均预装了 Lambda Stack、InfiniBand 驱动程序和 deepspeed 0.10.0,并同步到共享存储以用于训练数据和预训练权重。

主要结果

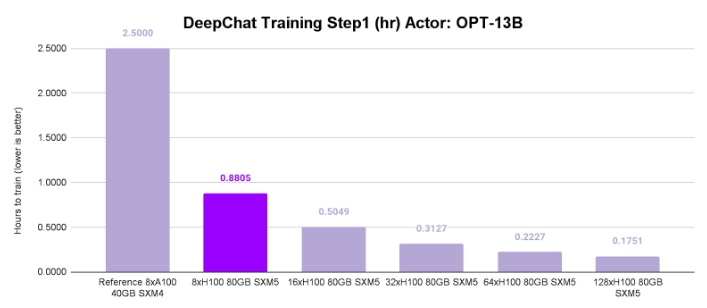

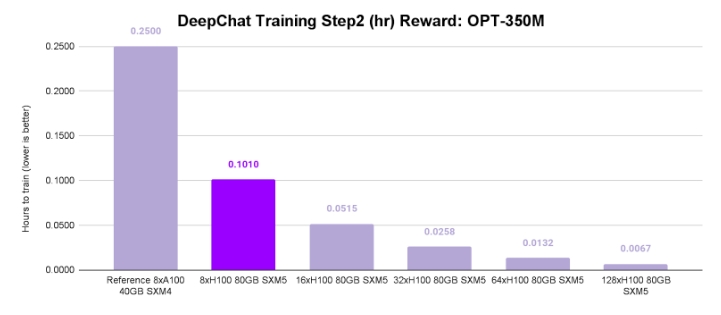

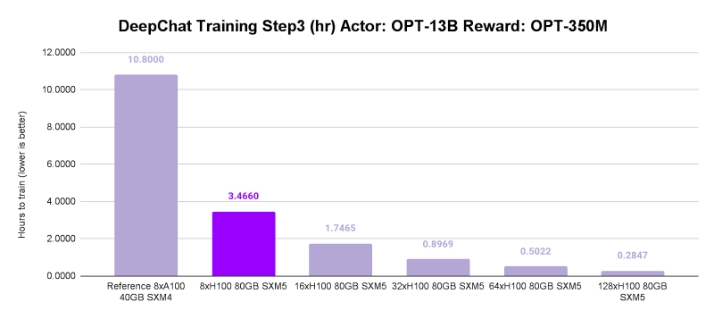

捷智算平台的 NVIDIA H100 SXM5 与 NVIDIA A100 SXM4 实例在 FP16 中的 3 步强化学习人类反馈 (RLHF) 管道上的正面比较显示:

步骤 1(OPT-13B Zero3):NVIDIA H100 速度提高 2.8 倍。

步骤 2(OPT-350M Zero0):NVIDIA H100 获得 2.5 倍速度优势。

步骤 3(OPT-13B Zero3 加 OPT-350M Zero0):NVIDIA H100 以 3.1 倍的速度提升遥遥领先。

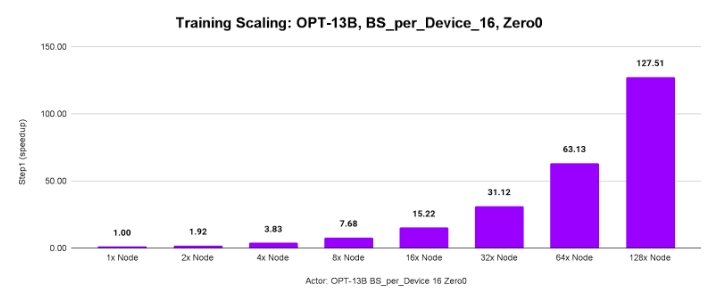

测试分布式训练可扩展性:

大型模型(OPT-13B)和更大的批次(16 个样本/GPU)导致 128 台服务器的吞吐量达到 127.51 倍。

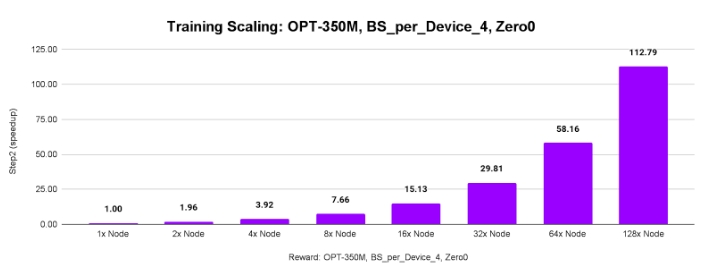

较小的模型(OPT-350M)和较小的批次(4 个样本/GPU)仍然令人印象深刻,128 台服务器的吞吐量达到 112.79 倍。

结论

与 NVIDIA A100 SXM4 系统相比,NVIDIA H100 SXM5 系统上的 DeepSpeed 训练速度提高了 2.5 倍至 3.1 倍。捷智算平台配备 80GB NVIDIA H100 SXM5 GPU、NIC 与 GPU 比率为 1:1 的 InfiniBand 连接以及轨道优化网络。它们可以在数千个 GPU 上提供前所未有的性能和可扩展性。